pyspark로 개발하다 보면 local에서 돌릴때는 정상적으로 돌아가는데 cluster mode(yarn 등)으로 실행할때 아래와 같이 오류가 발생하는 경우가 있습니다.

사실 spark가 돌아가는 방식에 대해 이해하면 쉬운데, 결론부터 말하자면 worker node에 해당 모듈이 깔려 있지 않아서 발생하는 오류입니다.

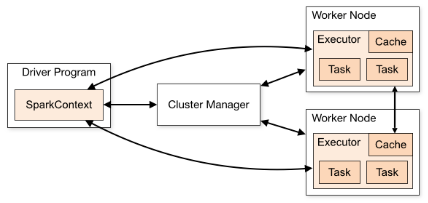

위 그은Spark가 Cluster deployment mode로 돌아가는 것을 형상화 합니다. 실제로 돌아가는 Task는 각 worker node에서 수행하기 때문에 각 worker node에 module 이 존재하지 않으면 module을 못찾게 되는 것입니다.

'빅데이터 > 하둡' 카테고리의 다른 글

| 하둡 맵리듀스 접근법 (0) | 2020.11.24 |

|---|---|

| HDFS cilent 사용시 HA구성된 node 연결하기 (0) | 2020.03.11 |

| pyspark에서 gzip으로 압축되어 있는 파일 읽는 방법 (0) | 2020.02.11 |

| [local hadoop]localhost port 22: Connection refused 에러 발생시 해결방법 in MacOS (0) | 2020.01.16 |

| Java로 AWS s3에 간단히 file write하기(hadoop-aws 라이브러리 사용, NativeS3FileSystem) (0) | 2019.07.11 |

| Hadoop에서 hadoop job은 어떻게 각 data node에서 job을 수행할까? (0) | 2018.12.17 |